– oder doch nicht?

Stellen Sie sich vor, Sie unterhalten sich mit einem Chatbot.

Sie schildern ein Problem, und der Bot antwortet: «Erzählen Sie mir mehr darüber.»

Plötzlich wirkt es, als würde er zuhören – vielleicht sogar verstehen.

Doch in Wahrheit hat er lediglich ein vorprogrammiertes Muster erkannt.

Wie funktionierte Eliza - und warum entstand der Eliza-Effekt?

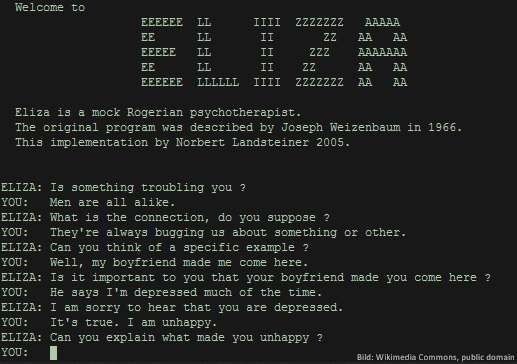

ELIZA wurde Mitte der 1960er-Jahre vom Informatiker Joseph Weizenbaum am MIT entwickelt. Das Programm simulierte einen Gesprächspartner – genauer gesagt eine Psychotherapeutin nach dem Vorbild der klientenzentrierten Gesprächsführung von Carl Rogers. Technisch arbeitete ELIZA nach einem einfachen Prinzip: Es analysierte Eingaben nach bestimmten Schlüsselwörtern, griff dann auf vordefinierte Antwortmuster zurück und gab diese in leicht abgewandelter Form wieder aus. Sagte jemand etwa: «Ich bin traurig», antwortete ELIZA mit «Warum sind Sie traurig?», unabhängig vom tatsächlichen Inhalt oder emotionalen Kontext.

Dabei war ELIZA ein konkretes Computerprogramm, das auf einem realen Computer lief (damals z. B. IBM 7094) und einfache sprachbasierte Interaktionen ermöglichte. Es arbeitete mit simplen Pattern Matching und einem Regelkatalog, nicht mit echter semantischer Verarbeitung, wie wir es von heutigen KI-Modellen kennen.

Trotz dieser simplen Mechanik sprachen viele Nutzer:innen mit ELIZA, als sei es ein echtes Gegenüber. Der sogenannte Eliza-Effekt beschreibt genau dieses Phänomen: Menschen neigen dazu, auch sehr einfachen textbasierten Systemen menschliche Eigenschaften zuzuschreiben – vor allem, wenn die Kommunikation sprachlich erfolgt und die Maschine scheinbar Verständnis zeigt.

Weizenbaum:

"I had not realized ... that extremely short exposures to a relatively simple computer program could induce powerful delusional thinking in quite normal people.

Mir war nicht klar, ... dass eine extrem kurze Exposition gegenüber einem relativ einfachen Computerprogramm bei ganz normalen Menschen ein starkes wahnhaftes Denken auslösen kann."

Warum fällt der Eliza-Effekt heute mehr ins Gewicht denn je?

In einer Welt voller KI-gestützter Tools, virtueller Assistenten und automatisierter Kundenservices ist es verlockend, zu vergessen, dass diese Systeme keine eigenen Gedanken oder Gefühle haben. Sie reagieren, sie imitieren – aber sie verstehen nicht im menschlichen Sinne.

Doch genau das wird häufig übersehen. Wenn ein Chatbot einfühlsam wirkt oder ein Sprachassistent humorvoll antwortet, entsteht beim Gegenüber schnell der Eindruck echter Kommunikation. Das kann hilfreich sein – etwa, um Hemmschwellen abzubauen oder Prozesse zu beschleunigen. Es kann aber auch zu Fehlwahrnehmungen führen, wenn Menschen zu viel Vertrauen in eine Maschine setzen.

Was bedeutet das für Unternehmen und digitale Services?

Wer digitale Schnittstellen anbietet, sei es im Kundenservice, im Vertrieb oder im internen Workflow, sollte den Eliza-Effekt im Blick behalten:

- Transparenz: Nutzer:innen sollten verstehen, ob sie mit einem Menschen oder einem System interagieren.

- Gestaltung: Sprache und Design sollten Erwartungen steuern, nicht überhöhen.

- Verantwortung: Systeme sollten so programmiert sein, dass sie nicht nur effizient, sondern auch ethisch sauber funktionieren.

Denn eines ist klar: Gute Technologie ersetzt keine echte Empathie – sie ergänzt sie. Umso wichtiger ist ein durchdachtes Design, das den Menschen im Mittelpunkt behält.

Wie wir als AGIS damit umgehen – und was unsere Software daraus macht

In unseren Produkten setzen wir gezielt auf intelligente Automatisierung – aber ohne den Anspruch, «menschlich» zu wirken, wo es nicht angebracht ist. Unsere Tools unterstützen, vereinfachen, analysieren, aber ohne zu blenden. Wir wissen: Verlässlichkeit, Klarheit und eine offene Kommunikation sind die besten Brücken zwischen Mensch und Maschine.

Der Eliza-Effekt erinnert uns daran, wie leicht sich Faszination in Fehlinterpretation verwandeln kann.

Unsere Antwort darauf: Technik mit Charakter – aber mit Bodenhaftung.

Neugierig wie das bei uns ausschaut?

Hier erfahren Sie mehr

Ausserdem:

Hören Sie hier einen Vortrag des US-amerikanischen Informatikers, Kognitionswissenschaftlers und Pulitzerpreisträgers:

Douglas Hofstadter zum Thema Algorithmen und Gefühl

und mehr zur Erklärung des Eliza-Effekts finden Sie hier im Video:

YouTube: Eliza-Effekt

Verwandt mit diesem Thema siehe auch früherer Blogbeitrag:

Quellen:

https://www.ibm.com/de-de/think/insights/eliza-effect-avoiding-emotional-attachment-to-ai

https://de.wikipedia.org/wiki/Joseph_Weizenbaum

https://de.wikipedia.org/wiki/ELIZA-Effekt

https://de.wikipedia.org/wiki/ELIZA

Autorin: Mina Bösiger